Claudio Della Volpe

Come ho già discusso in un recente articolo su C&I (I chimici e i dervisci, C&I , 3, 2019 purtroppo non disponibile al pubblico) in Natura certi legami chimici appaiono meno probabili e meno comuni; il legame carbonio fluoro (C-F) per esempio non sembra in grado di integrarsi bene almeno nella biosfera terrestre, ma è alla base di una parte importante della nostra chimica di sintesi.

Il motivo è probabilmente la grande forza del legame:

Legame singolo- Energia di legame (kcal/mol)

C-S 62.0

C-Br 65.9

C-Cl 78.5

C-C 83.1

C-O 84.0

C-H 98.8

C-F 105.4

Come si vede il legame C-F appare il più forte fra tutti i legami del carbonio e dunque il più difficile da scalfire. Pochi esseri viventi usano legami carbonio fluoro; per esempio la nucleocidina prodotta da una muffa e la fluorotreonina isolata dal mezzo di cultura del microorganismo Streptomices Cattleya. Non sembrano esistere materiali perfluorurati naturali; la superidrofobicità naturale (come quella del Loto o del comune Cavolo cappuccio) deriva da cere normali che cristallizzano in geometrie particolari. Per completezza ricordiamo qui che esiste almeno una pianta superiore , Dichapetalum cymosum che produce spontaneamente come sostanza di difesa dagli erbivori il fluoroacetato.

Come agisce? Il composto in se non è tossico ma nel corpo reagisce con il coenzima A producendo il fluoroacetilcoenzima A. A sua volta questo reagisce con l’ossaloacetato per formare fluorocitrato che è tossico perchè è un substrato alternativo per l’aconitasi dalla quale non si separa più; un po’ come il monossido di carbonio per l’emoglobina. La conseguenza è l’interruzione del ciclo di Krebs e della respirazione cellulare, ossia la morte.

E’ da dire che ci sono alcune altre piante in grado di sintetizzare il fluoroacetato. La fluoroacetaldeide è anche l’intermedio di sintesi biologica dei cosiddetti ω-fluoro acidi grassi e del fluoroacetone. Comunque è interessante notare che NESSUN animale usa o sintetizza composti fluorurati composti con legami C-F (a parte quelli di sintesi umani ovviamente).

L’enzima capace di costruire un legame C-F si chiama adenosil-fluoruro sintasi o fluorinasi ed è l’unico conosciuto.

Si tratta, come si vede, di un numero ridotto di casi che entrano in circolo grazie ad un unico enzima.

Al contrario della Natura la chimica del legame C-F non ha fermato l’uomo dall’introdurre un elevato numero di composti basati su questo legame a causa proprio della stabilità e delle proprietà speciali che questo legame conferisce alle molecole che ne sono dotate.

Molecole con legami C-F in particolare con tutti i legami saturati dal fluoro , ossia composti perfluorurati sono stati introdotti perché da una parte sono estremamente idrofobici, sono le sostanze a più bassa energia superficiale che si conoscano, meno di 10 mJ/m2, tendono ad avere una bassissima coesione, dunque sono cere amorfe se di grande dimensioni di catena oppure liquidi, stabili per lungo tempo e con elevate tensioni di vapore.

La somma di queste proprietà li ha portati a dominare certi settori: polimeri perfluorurati come il teflon, PTFE (https://ilblogdellasci.wordpress.com/2015/10/29/quanta-chimica-ce-nelle-bombe-atomiche-3/), liquidi perfluorurati come alcuni tipi di freon, utili nei circuiti frigoriferi o per scacciare l’acqua da mezzi porosi, rivestimenti antiaderenti o antibagnatura, cere da sci più performanti, insomma settori molto utili e dunque anche lucrosi.

Purtroppo si è visto che la stabilità di queste catene perfluorurate o parzialmente fluorurate è tale solo a certe condizioni: la presenza di eteroatomi (per esempio H) anche se alogeni (è il caso di CFC e HFC) e l’effetto degli UV o di un forte riscaldamento, porta ad una loro decadenza nel tempo; una delle conseguenze di questo fatto è stato il cosiddetto buco dell’ozono; l’altro effetto l’intossicazione con derivati perfluorurati di persone ed ambienti, di cui ci ha parlato varie volte Mauro Icardi. (https://ilblogdellasci.wordpress.com/2018/04/23/emergenza-in-veneto/)

Per comprendere meglio la natura dell’inerzia dei perfluorurati facciamo un confronto fra due sostanze più semplici: cloroformio e fluoroformio.

molto simili come vedete; ora entrambi sono debolmente acidi:

HCCl3 ->H+ + CCl3–

HCF3 ->H+ + CF3–

La carica negativa sullo ione viene stabilizzata dall’effetto attrattivo degli alogeni; però succede una cosa interessante: l’acidità del cloroformio è MAGGIORE di quella del fluoroformio. Eppure la elettronegatività del fluoro è maggiore di quella del cloro; la sua capacità di attirare cariche negative maggiore; come si spiega?

Si spiega col fatto che la carica negativa da una parte deve stare; con gli atomi di cloro essa entra a far parte delle zone dominate dagli orbitali d del cloro che dunque ha due meccanismi di stabilizzazione. Invece il medesimo meccanismo manca al fluoro, perchè il fluoro NON HA ORBITALI d!!

Dunque non sa dove mettere quell’eccesso di carica negativa che pure può attrarre tranquillamente; questo è anche il motivo dell’inerzia chimica dei perfluorocomposti: per attivarsi devono poter avere uno spazio dove ficcare gli elettroni che la eccezionale forza di attrazione del fluoro mette a disposizione.

Ed ecco allora che o ci vogliono radiazioni capaci di ionizzare i legami, oppure ci vogliono eteroatomi, zone di più bassa elettronegatività per poter ospitare una quota di quella nuvola elettronica.

Conseguenza: i perfluorurati sono inerti. Troppo forti per lo spazio disponibile.

Tuttavia i composti perfluorurati con lo “spazio” opportuno sono reattivi; dunque gli intermedi delle lavorazioni industriali come PFOA o PFOS riescono prima o poi ad accumularsi da qualche parte e produrre effetti nocivi; come si è visto nel nostro Veneto o in USA, dove la malaccorta gestione degli scarichi (in Italia della Miteni, in USA della Dupont) ha condotto ad una profonda alterazione ambientale, in Veneto della falda idrica tramite la quale l’inquinamento è passato nei corpi delle persone. Ci abbiamo scritto vari post:

https://ilblogdellasci.wordpress.com/2018/04/23/emergenza-in-veneto/

https://ilblogdellasci.wordpress.com/2017/12/08/questione-pfas-ovvero-larte-di-spostare-il-problema/

Finora tuttavia nessuno aveva trovato il modo di risolvere il problema posto dall’accumulo di perfluorurati nel suolo e nelle acque; come depurare l’ambiente da queste molecole così “estranee” alla biosfera?

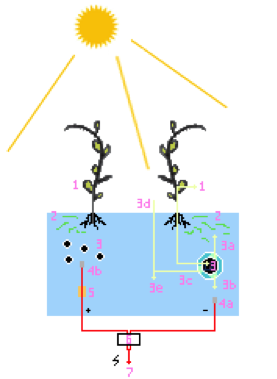

In questo lavoro che vi presento, comparso in questi giorni su Environmental Science and Technology, due colleghi di Princeton dimostrano che una particolare sottospecie di batterio, Acidimicrobium Strain sp. A6 è in grado di metabolizzare il fluoro organicato usando vari coreagenti: mentre idrogeno e ammoniaca si ossidano cedendo elettroni e dunque riducendo il Fe+2, anche il perfluorurato entra in gioco rompendo la propria catena e producendo ioni fluoruro. In effetti la ricerca di Jaffe e Huang aveva altri scopi. I due ricercatori , finanziati dalla Fondazione Shipley (i cui fondi vengono dall’industria chimica americana e in particolare da una azienda interessata ai materiali con cui si fanno le piastre per i circuiti stampati, fra i quali cito a memoria ci sono le cere perfluorurate; lo so perché le ho usate come riferimento dei più idrofobici materiali disponibili per l’angolo di contatto) il loro lavoro era dedicato alla degradazione dell’ammoniaca nei terreni umidi del New Jersey, in particolare usando classi di batteri capaci di un processo naturale chiamato Feammox; dopo parecchi anni di lavoro hanno isolato il batterio responsabile che è appunto l’Acidimicrobium A6.

In effetti la ricerca di Jaffe e Huang aveva altri scopi. I due ricercatori , finanziati dalla Fondazione Shipley (i cui fondi vengono dall’industria chimica americana e in particolare da una azienda interessata ai materiali con cui si fanno le piastre per i circuiti stampati, fra i quali cito a memoria ci sono le cere perfluorurate; lo so perché le ho usate come riferimento dei più idrofobici materiali disponibili per l’angolo di contatto) il loro lavoro era dedicato alla degradazione dell’ammoniaca nei terreni umidi del New Jersey, in particolare usando classi di batteri capaci di un processo naturale chiamato Feammox; dopo parecchi anni di lavoro hanno isolato il batterio responsabile che è appunto l’Acidimicrobium A6.

Il momento successivo è stato la sostituzione di un elettrodo al Fe come accettore per poter agire su terreni poveri di ferro. Nello svolgere le prove di questo lavoro si resero conto della possibilità che si apriva nei confronti sia di materiali clorurati, che perclorurati ed a questo punto hanno provato ad aggredire i perfluorurati.

Prima di loro l’uso di alcune specie di Pseudomonas aveva portato ad un risultato apparentemente simile ma senza produzione di ione fluoruro, dunque senza l’eliminazione del fluoro organico.

Per la prima volta abbiamo dunque davanti la possibilità di estrarre un sistema enzimatico e attivare artificialmente reazioni in grado di attaccare il legame C-F il legame del carbonio più forte che conosciamo; questo ci dà speranza che si possa fare qualcosa contro l’inquinamento da PFOA e PFOS.

Ma la storia ci fa anche capire che l’industria che ha provocato in modo malaccorto (o peggio) i problemi, può anche risolverli finanziando una opportuna ricerca dotata di serendipità. Lo Stato dovrebbe supportare queste linee di ricerca. Ovviamente sarebbe meglio prevenire i problemi, come ha saggiamente scritto pochi giorni fa Luigi Campanella in un post sulle microparticelle.

http://www.dmf.unisalento.it/sub-web/AerosolClima/

http://www.dmf.unisalento.it/sub-web/AerosolClima/

https://tg24.sky.it/ambiente/2018/01/22/cosmetici-microplastiche.html

https://tg24.sky.it/ambiente/2018/01/22/cosmetici-microplastiche.html https://tg24.sky.it/ambiente/2018/01/22/cosmetici-microplastiche.html

https://tg24.sky.it/ambiente/2018/01/22/cosmetici-microplastiche.html